REASONING ON GRAPHS: FAITHFUL AND INTERPRETABLE LARGE LANGUAGE MODEL REASONING

第一作者:Linhao Luo

作者单位:Monash University

发表时间:2024/2

发表期刊:ICLR 2024

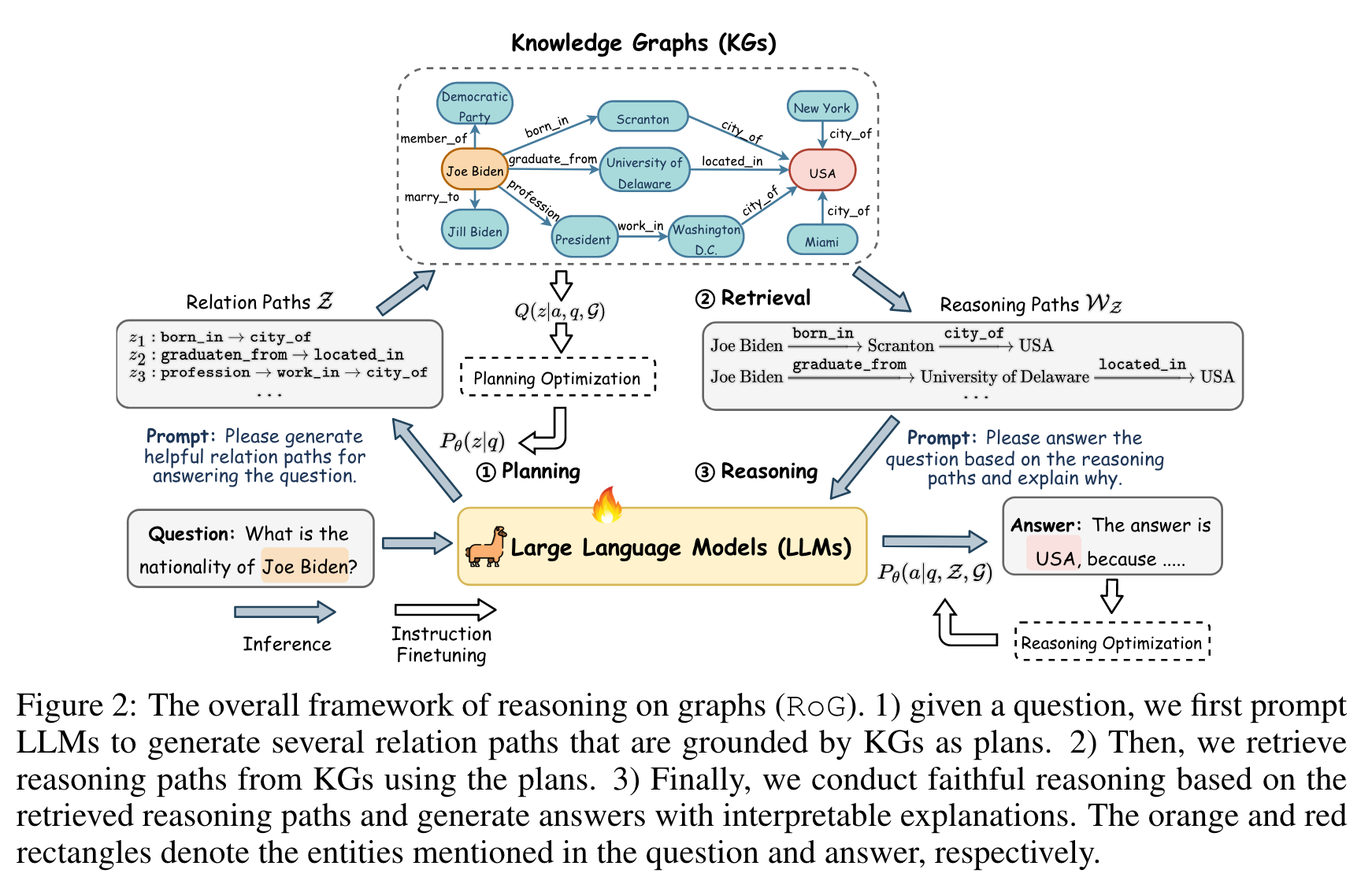

关键内容:先利用LLM 生成与问题回答 有关的关系路径,再到KGs中进行检索(实体来自问题句子,关系来自LLM生成的关系),再利用检索到的推理路径进行模型推理。亮点在于:知识图谱中的实体会动态变化,而实体间的关系是较为稳定的,通过对KG中关系路径的检索得到可靠的知识作为模型的上下文输入。

1.引言

先前使用 KGs 和 LLMs 进行推理的方法有以下两种:

- 语义解析,通过 LLMs 将问题转化为逻辑查询,在KGs中进行查询,与ChatKBQA类似。这种方法的缺点在于生成的逻辑查询不一定是可执行的。(因此,ChatKBQA会对逻辑查询中的实体/关系进行无监督检索替换,以确保逻辑查询的可执行性)

- RAG。将KGs作为LLM推理的事实知识库,没有充分利用KGs结构信息。For instance, as shown in Figure 1, a relation path, which is a sequence of relations, “child of -> has son” can be used to obtain answers to the question “Who is the brother of Justin Bieber?”.

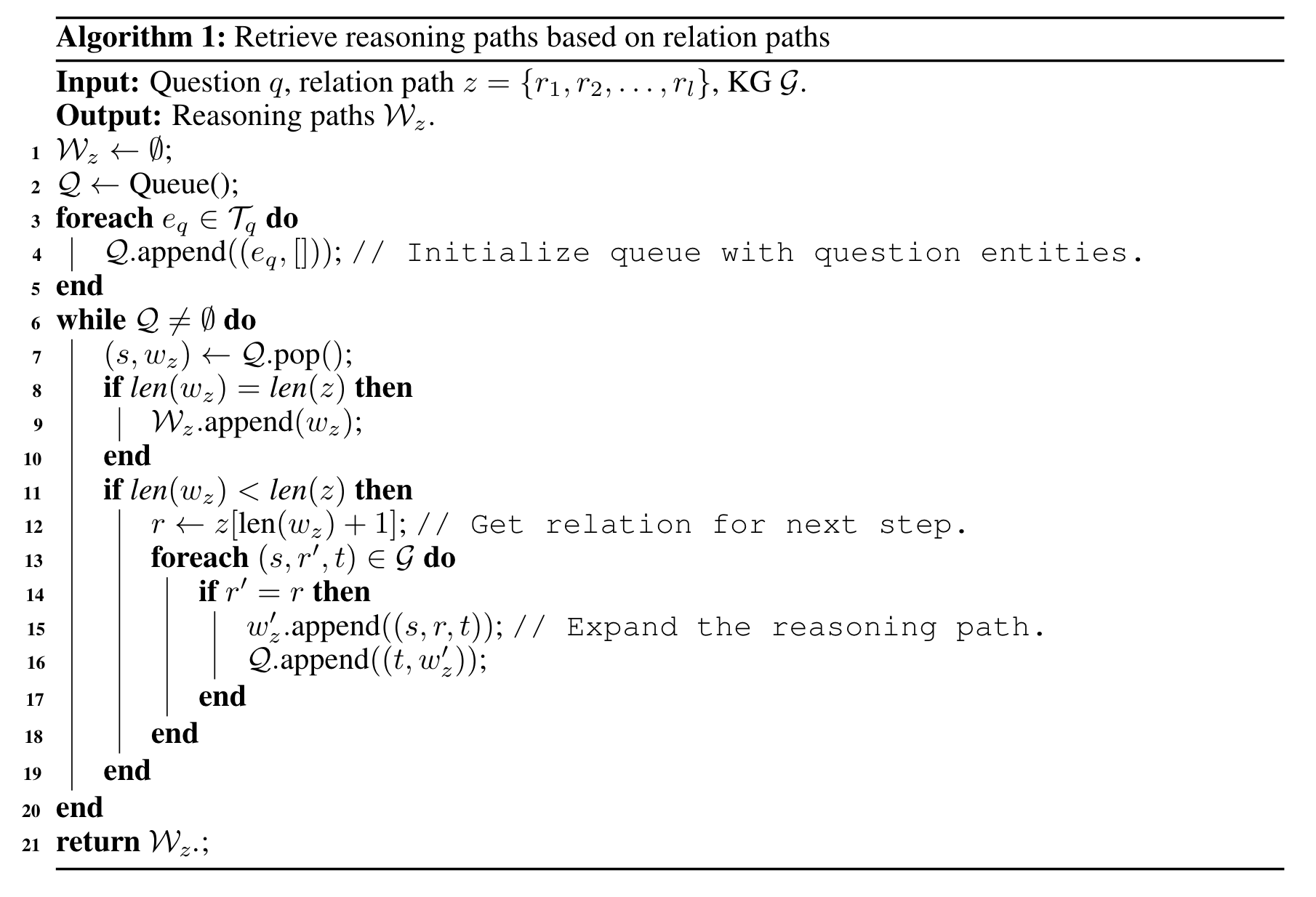

因此,不同于ChatKBQA中利用LLM生成逻辑查询,RoG是先通过LLM生成关系路径,再对KGs进行检索,最后将检索得到的推理路径作为上下文输入到LLM中进行推理。

2.实验

-

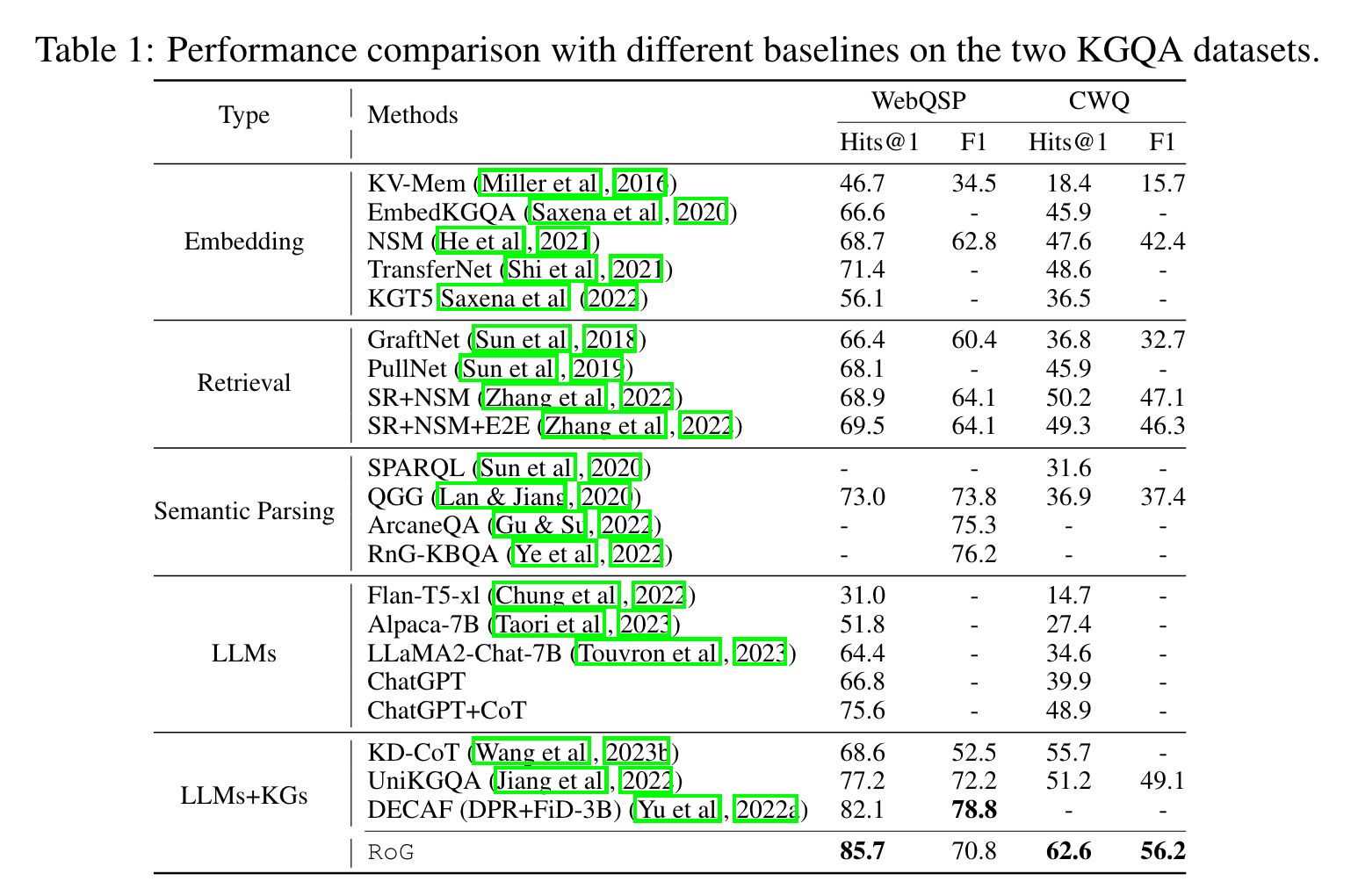

RoG与其它模型比较,其中,type 为LLM的模型并没有进行微调,同时为zero shot inference。RoG的基座模型为 LLaMA2-Chat-7B,微调数据集为WebQSP、CWQ、Freebase。

-

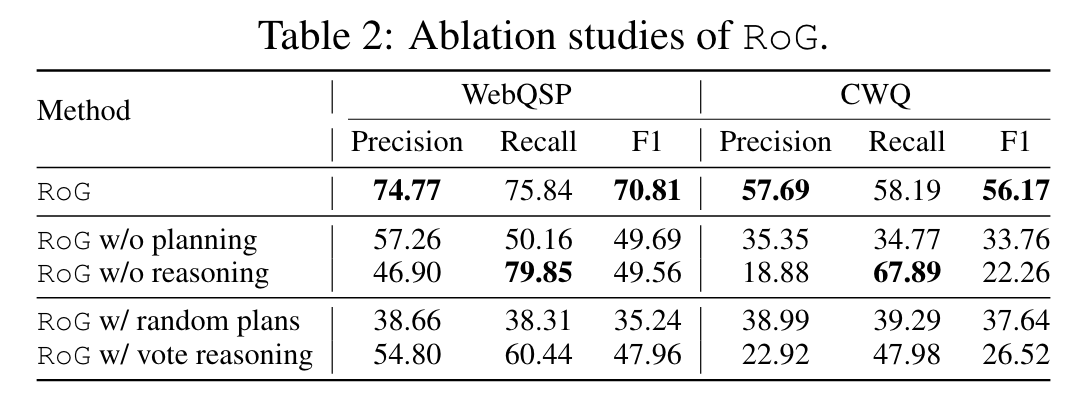

消融实验。w/ random plan,从KGs中随机检索推理路径,并将其输入到推理模块中;w/ vote reasoning,采用多数投票,从检索到的推理路径中选择前5个答案。

-

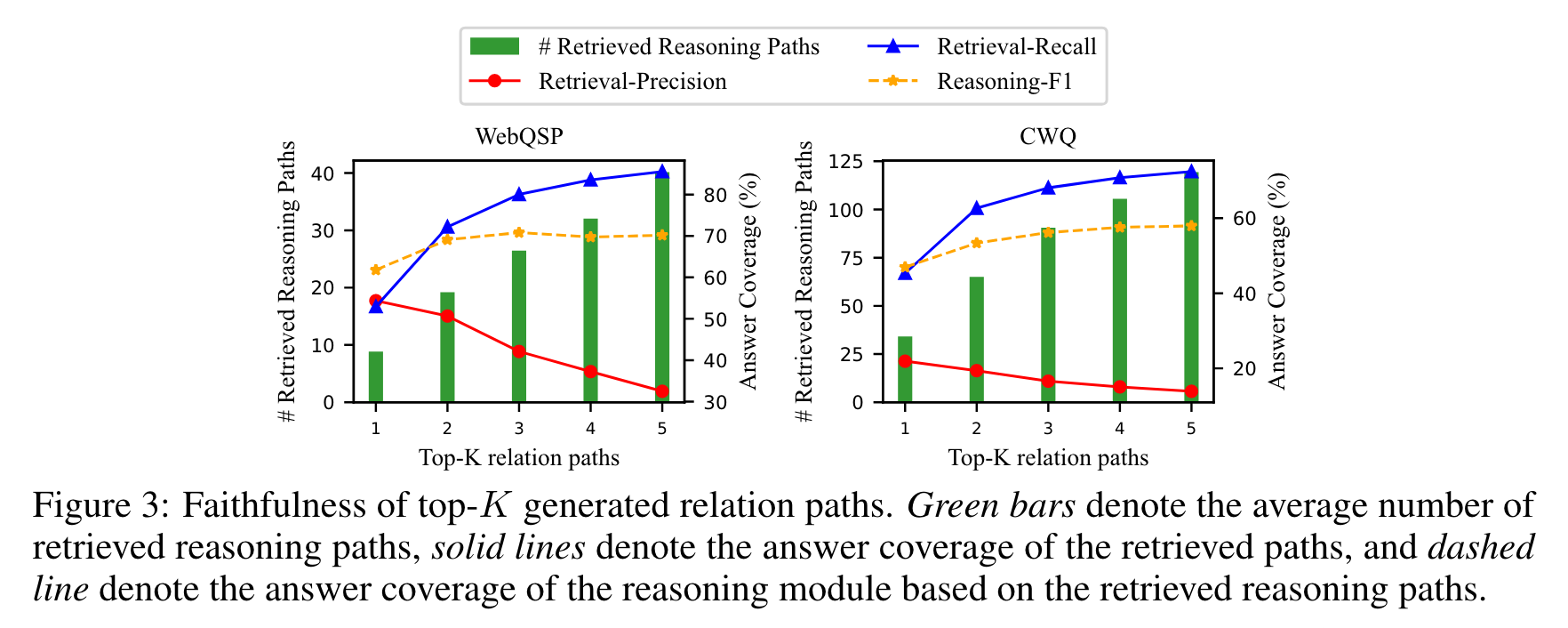

探究超参数——关系路径数量的影响。关系路径数量越多,召回率越高,但也引入更多噪声,精确度下降。

-

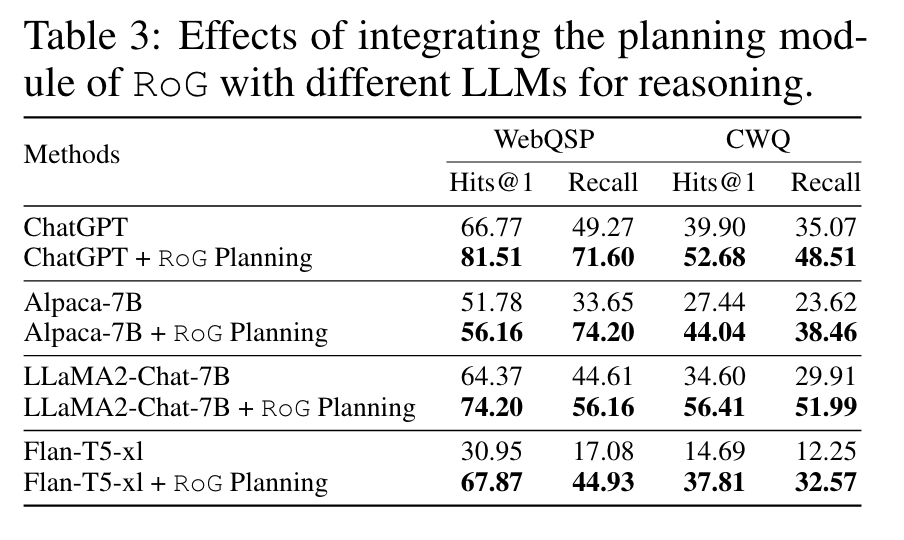

PLUG-AND-PLAY ROG PLANNING MODULE 的验证

3. 参考文献

Luo L, Li Y F, Haffari G, et al. Reasoning on graphs: Faithful and interpretable large language model reasoning[J]. arXiv preprint arXiv:2310.01061, 2023.